언어모델 (Language Model)이란 개념이 등장한 지도 이미 반세기가 지났고 현대적 LM을 알린 Transformer 논문이 나온 지도 이미 7년이 지났지만, 오늘날의 LLM은 ChatGPT가 대중에 공개된 2022년 11월, 즉 겨우 2년 미만의 시간이 지났다. 어쩌다 보니 작년 초부터 LLM을 중심으로 AI 기술의 발전을 매달 정리해서 발표했는데, 이번에는 전체 팀원을 대상으로 지난 8, 9월의 트렌드를 소개하게 됐다. 몇 명의 새로운 멤버가 세미나에 참석할지는 모르겠으나 지난 1년 반 동안의 발표를 놓친 이들에게 8월에는 이런 서비스가 출시했고 9월에는 이런 논문이 나왔어요라고 발표하기에는 무리가 있어서 지난 2년 간의 LLM/AI 연구를 한 장에 정리했다. 요즘은 학계 연구보다는 산업계의 신제품이 더 임팩트를 주지만, 회사나 제품보다는 연구 중심으로 아래와 같이 정리했다. 그리고 생성형 AI의 다른 축을 차지하는 디퓨젼 모델은 제외하고 LLM을 중심으로 정리했음을 미리 알린다.

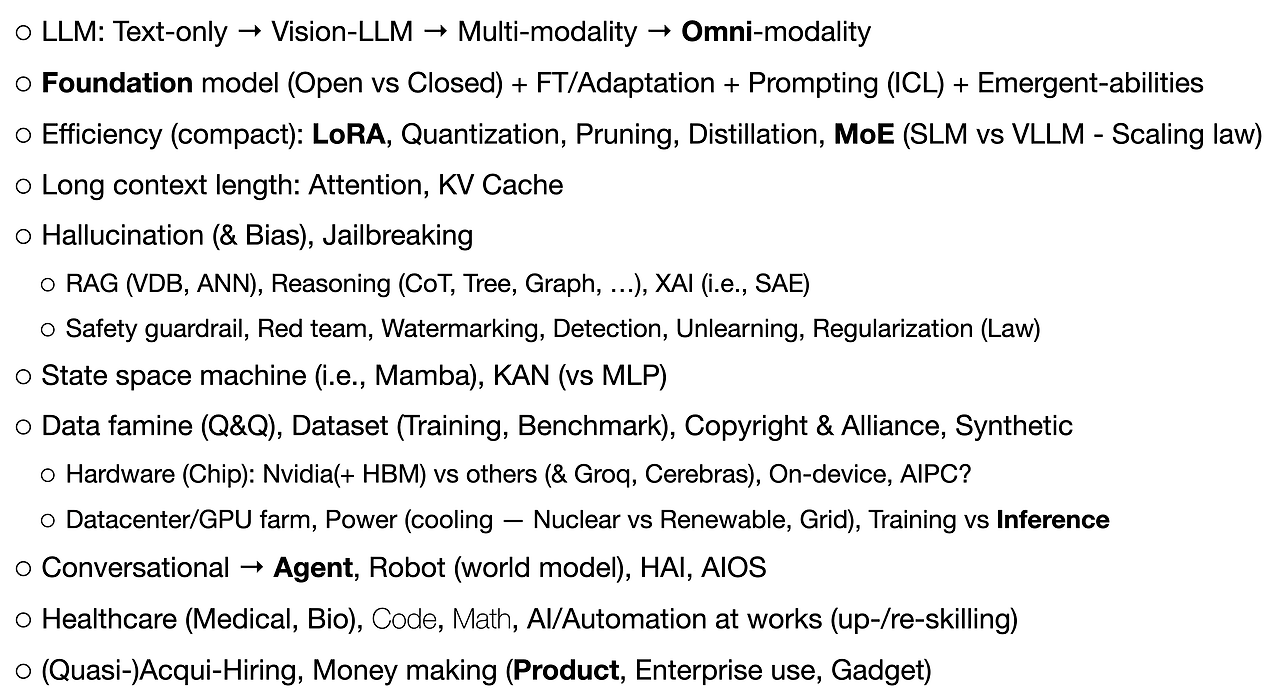

이 분야에 관심을 갖고 있다면 긴 설명이 필요치 않아 보이지만, 그렇지 못한 이들을 위해서 간략히 설명을 더한다. 처음 LLM (특히 ChatGPT)이 등장했을 때는 ‘언어 모델’이라는 명칭이 암시하듯 전적으로 텍스트 기반이었다. 몇 개월 후 ChatGPT 4가 나오면서 이미지를 이해하는 Vision-LLM이 갑자기 쏟아졌고, 바로 비디오나 음성/음악 등의 다른 모달리티를 포함하는 Multi-modal LLM이 주를 이뤘다. 그리고 최근 ChatGPT-4o와 함께 Omni-modal LLM으로 이어졌다. Multi-modality와 Omni-modality의 구분은 각각의 모달리티를 별도의 인코더로 처리하느냐 아니면 하나의 인코더로 모든 모달리티를 한꺼번에 처리하느냐의 차이로 이해하면 된다.

전통적으로 AI 모델은 특정 문제에 특화된 형태로 구축, 학습됐지만, 생성형 AI의 시대에는 여러 문제에 범용적으로 적용가능한 기본 모델을 구축하고 이를 개별 문제나 상황에 맞게 커스터마이징 하는 형태가 주를 이룬다. Foundation model (FM)이라는 기본 모델에 입력값을 넣으면, 즉 프롬프팅 Prompting 하면 그럴듯한 결괏값을 얻을 수 있다. 파운데이션 모델이 커지면서 작은 모델이 갖지 못한 새로운 기능들 emergent abilities이 생겨났고 이를 규명하려는 시도도 많았다.

큰 모델 사이즈는 더 나은 성능을 약속하지만 더 많은 학습데이터, 더 많은 컴퓨팅 리소소를 요구하기 때문에 로컬 머신, 심지어 스마트폰에서 구동하기 위한 효율화를 추구하는 것이 연구의 큰 줄기였다. 양자화 Quantization이 가장 큰 주목을 받았지만 기존의 Pruning이나 Distillation 기법도 많이 활용된다. LoRA (Low Rank Adaptation)는 FM의 사이즈를 줄이지는 못하지만 전체 모델의 fine-tuning 없이 모델의 커스터마이징이 되기 때문에 LoRA 쪽 논문도 한동안 많이 발표됐다. 그리고 프랑스 Mistral사의 Mixtral 모델이 소개된 후로는 MoE (Mixture of Experts) 기반의 모델이 많이 등장해서 추론 inference 효율화를 이루고 있다. 메이저 테크 기업을 중심으로 강력한 VLLM이 등장하지만 중소형 기업이나 학계를 중심으로 한 SLM의 가능성도 한 축을 이룬다. 모델 효율화와 함께 인풋/context의 길이를 늘이는 연구도 큰 성과를 이뤘다. 초기에는 약 4천 토큰 미만의 모델들이 주를 이뤘지만, 어느덧 12.5만 토큰 그리고 구글의 특정 Gemini 모델은 2M 토큰까지 지원하는 수준에 이르렀다. 이때 Attention 모델을 개선하는 연구와 KV Cache를 사용하는 연구가 주를 이뤘다.

LLM이 강력하지만, 한편으로는 원치 않은 결과물을 내놓는 Hallucination 현상은 초기부터 문제로 지적됐다. 뿐만 아니라 다양한 형태의 Jailbreaking을 통해서 인류에게 해로운 결과물을 쏟아내는 취약성도 있다. Hallucination을 막기 위해서 많은 연구가 진행됐지만, 그 정점에는 RAG (Retrieval-Augmented Generation)가 있다. RAG를 위해 벡터 기반의 DB 기술, Approximation 기반의 유사도 추론 기술도 함께 주목받고 있다. 다른 한편으로는 Reasoning 방식도 향상됐는데 대표적으로 CoT (Chain-of-Thoght)이 있고 이후로 Tree나 Graph 등으로 확장됐다. 방향성은 다소 다르지만 Sparse Auto-Encoder를 위시한 여러 XAI (eXplainable AI) 기술도 주목받고 있다. LLM의 다른 취약성을 보완하기 위해서 여러 Safety guardrail이나 red team 방식도 소개되고, AI 결과물에 워터마크를 삽입하거나 AI 저작물을 검출하는 기술도 함께 발전하고 있다. 저작권 이슈와 함께 Unlearning도 중요한 연구가 될 거다.

트랜스포머 모델의 한계 (Quadratic Complexity)를 극복하기 위해서 Mamba로 대표되는 State-space 모델도 많은 주목을 받고 있으며, Connection weight 기반의 MLP를 대체하는 KAN (Kolmogorov Arnold Network)가 24년 상반기에 소개된 후로 여러 후속 연구가 이어지고 있다. 최근에는 트랜스포머의 FFN을 KAN으로 대체하는 KAN-Transformer도 소개된 바 있다.

사람들의 기대가 커짐과 함께 AI 모델의 사이즈 경쟁은 더 치열해지고 있다. 그런데 그런 대형 모델을 학습하는데 필요한 데이터는 한계를 드러내고 있다. 현재 웹에 축적된 데이터로는 향후 수년 내에 필요한 데이터를 충족시키지 못할 거라는 예측도 나왔다. 그래서 지금 LLM은 GPU로 대표되는 하드웨어 쟁탈과 함께 데이터 쟁탈전이 가장 큰 화두다. 학습 데이터를 수집, 정리하고 여러 벤치마킹 데이터를 구축하는 여러 시도가 있지만, 저작권으로 대표되는 큰 허들을 넘을 수 있을 것인가가 관건이다. 그래서 인공 데이터에 관심을 갖기 시작했지만, 이도 AI의 아웃풋으로 학습된 AI의 성능은 떨어진다는 치명적 문제를 해결해야만 한다. LLM 전쟁에서 현재로선 Nvidia가 가장 큰 승자지만, 다른 빅테크 기업들도 Nvidia에 대항하기 위한 여러 노력을 기울이고 있다. 특히 추론을 위해서 Groq이나 Cerebras 등의 스타트업의 성과가 눈에 띈다. 그리고 데이터센터를 구동하기 위한, 특히 쿨링을 위한 전력을 수급하는 것도 큰 이슈인데, 당장은 핵발전에 관심을 갖고 있지만 장기적으로 신재생 에너지로의 전환이 필요하고, 그렇기 때문에 노후화된 전력망 Grid을 대체하는 산업도 큰 주목을 받고 있다.

LLM이 등장했을 때 초반에는 대화형 Conversational XX 과련 논문이 많이 나왔으나 몇 달이 지난 후로는 단순 대화형이 아닌 완전 자동화, 즉 Agent로 연구가 집중되고 있다. 뿐만 아니라 World model을 갖춘 Robot, 특히 휴머노이드에 관한 연구도 많이 등장했다. 그러면서 HCI 개념이 AI로 들어와서 인간-AI 인터페이스/인터렉션 (HAI)에 관한 연구도 많이 보인다. 이제는 AI가 단순한 도구가 아닌 AI 자체가 컴퓨터 OS처럼 동작하리라는 AIOS 개념도 종종 회자된다.

지난 2년 동안 꾸준히 의료와 바이오 관련 논문들이 하루에 몇 편씩 쏟아지고 있다. 의료/헬스케어를 제외하고는 코딩/프로그래밍과 수학추론 Math reasoning에 관한 논문도 꾸준히 나오는 편이지만, 의료만큼 양과 꾸준함은 없다. 그리고 AI의 가장 핵심적인 용용처는 기업/산업계에서의 활용이다. 여러 기관에서 업무에서 AI의 수용도나 임팩트 등을 설문/조사한 연구가 꾸준히 나오고 있다. 모든 조사에서 일관성을 보이는 것은 아니지만, 그럼에도 AI 때문에 직업 또는 업무 형태가 바뀔 거라는 것은 분명하고 그렇기에 AI를 업무에 잘 적용하거나 아니면 다른 기술을 배워서 AI의 효과를 극복하기 위한 upskilling 또는 reskilling을 대부분의 연구에서 강조하고 있다.

마지막으로 빅테크를 중심으로 AI 인재를 모으려는 노력은 계속되고 있다. 그런데 기업 규제 때문에 예전과 같이 단순히 기업을 인수해서 인재를 영입하는 형태에서 벗어난 형태를 보이고 있다. MS-Inflection, Amazon-Adept, Google-Character.AI의 사례에서 보듯이 피인수기업과 그 서비스는 그대로 유지한 채 파운더를 비롯한 기요 기술자를 흡수하는 변형된 인수영입이 트렌드라면 트렌드다. 현재 AI는 전적으로 돈을 공중에 태우는 기술이다. 그래서 제대로 많은 돈을 벌 수 있는 제품, 서비스가 언제 출시되느냐에 따라서 새로운 AI 겨울이 오느냐 마느냐가 결정될 거다. 여러 AI 가젯들이 등장하고 있지만 과연 성공할 수 있을까?

끝